Actividades Transversales EDCTI Anteriores

Universidad de Granada | Escuela de Posgrado | Administración electrónicaBuscar

Actividades Transversales EDCTI Anteriores

Descargar versión en PDFCurso 2023/2024

Inteligencia Artificial en 360º

- Descripción breve

Es notorio que la Inteligencia Artificial (I.A.) permea todas las áreas de conocimiento y puede tener un impacto relevante en cuestiones sociales y económicas. Sin embargo, también es notorio que en muchos casos no se tiene conocimiento riguroso de sus potencialidades y limitaciones, entendiéndose más como un arcano con nombre bonito que como una disciplina científica bien asentada, que puede proporcionar soluciones a problemas para los que no las hay en todos los ámbitos del saber, y muy particularmente para muchas de las líneas de investigación más avanzadas (en las que se inscriben las tesis doctorales).

De cara a abrir ventanas de oportunidad para la investigación a partir de técnicas y modelos basados en I.A., es fundamental que los doctorandos conozcan de qué hablamos cuando hablamos de esa materia, cuáles son sus limitaciones y cuales sus perspectivas a corto plazo, desde un punto de vista científico, solido y riguroso.

En esta actividad de carácter esencialmente transversal y de máximo rigor científico, se plantea como objetivo principal clarificar las cuestiones básicas asociadas con la I.A., desterrar algunos de los mitos más usuales y proveer una explicación clara y sencilla de las principales técnicas que permiten la construcción de sistemas basados en IA.

- Ponentes

• David A. Pelta Mochcovsky. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

• Carlos Cruz Corona. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

• José Luis Verdegay Galdeano. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

• Jorge Sergio Igor Zwir Nawrocki. ETSI Informática y de Telecomunicación

• Margarita Robles Carrillo. Facultad de Derecho UGR

• Rocío Romero Zaliz. ETSI Informática y de Telecomunicación

- Perfil

Dirigido a estudiantes de las 3 Escuelas de Doctorado (EDCTI, EDCS y EDHCSJ).

- Contenidos (Programa preliiminar sujeto a cambios menores antes del comienzo del curso)

• Un recorrido histórico por la IA.

• Representación del conocimiento.

• “Machine Learning”.

• Métodos de Búsqueda y Optimización.

• Procesamiento del lenguaje natural.

• Técnica de Recuperación de la Información.

• Procesamiento de Imágenes y Video.

• Robótica e IA.

- Plazo de solicitud: del 5 al 17 de marzo de 2024

- Forma de solicitud: a través de este FORMULARIO

- Sesiones: 9, 11, 16, 18 y 23 de abril 2024

- Horario: de 16 a 20h

- Seminario de Aplicaciones de IA en fecha por confirmar

- Nº de plazas: 30 presenciales con evaluación / Modalidad online: sin límite de plazas

- Lugar : aula 0.1 de la Escuela Técnica Superior de Ing. Informática y de Telecomunicación

La modalidad principal del curso es presencial. Los participantes presenciales que superen la evaluación, obtendrán un diploma de aprovechamiento del curso. En caso contrario, se emitirá un diploma de asistencia (se requiere una asistencia mínima al 75% de las sesiones).

Previo registro, las sesiones del curso se podrán seguir de manera online. Los participantes en esta modalidad que hayan asistido, al menos, al 75% de las sesiones, podrán solicitar un diploma de asistencia.

- Evaluación:

La superación del curso requerirá:

1) la asistencia a (al menos) el 75% de las sesiones.

2) Realización de un informe bibliográfico.

Se podrá plantear de acuerdo a las dos vías siguientes:

a) Dado un problema de interés provisto por el/la estudiante, el informe recogerá que técnicas de IA se han aplicado para su resolución.

b) Dada una técnica de interés para el/la estudiante (por ej. técnicas de aprendizaje), el informe recogerá que problemas de su área se han resuelto con dicha técnica.

Los responsables del curso estarán abiertos a otras propuestas de trabajo.

Técnicas estadísticas avanzadas aplicadas en Ciencias Experimentales: fundamentos, interpretación e implementación en R

Ponentes:

• Dra. D.ª Beatriz Cobo Rodríguez.

• Dr. D. Ramón Ferri García.

• Dr. D. Christian Acal González.

Justificación académica del curso: :

Es incuestionable la importancia que en las últimas décadas ha experimentado la aplicación de numerosas técnicas probabilístico-estadísticas en múltiples campos de aplicación. La razón última de ello viene motivada por la necesidad de describir y explicar la evolución de fenómenos, no sólo desde un punto de vista cualitativo sino cuantitativo, a la vez que se hace imprescindible en múltiples ocasiones poder inferir comportamientos futuros de los sistemas que son objeto de estudio.

Continuando la línea del curso de Técnicas Estadísticas Básicas, el objetivo del curso es doble: por un lado, complementar algunos aspectos relativos a técnicas ya introducidas en el curso precedente y, por otro, presentar otras técnicas de carácter más avanzado y que son de amplio uso en múltiples campos de aplicación. Se hará hincapié sobre los fundamentos, condiciones de aplicabilidad e interpretación de resultados que ayuden a una mejor descripción de los fenómenos estudiados por los alumnos en el desarrollo de sus investigaciones. Otro de los objetivos del curso es el de mostrar la implementación de estas técnicas mediante R, introduciendo al alumno en el empleo de uno de los programas que mayor difusión ha adquirido en los últimos años.

Lugar de realización: Aula de informática O-04 (zona de Matemáticas de la facultad de Ciencias).

Plazas: 25

Duración: 25 horas

Modalidad: Presencial

Periodo de impartición: Del 3 al 7 de junio de 2024

Horario: De 09:00h a 14:00h

Plazo de solicitud: Del 9 al 15 de mayo de 2024

Forma de solicitud: A través del siguiente FORMULARIO

Programa:

1. Estudios avanzados en regresión lineal (Profa. Beatriz Cobo). Sesión: 3 de junio.• Diagnosis del modelo: análisis de residuos (normalidad, heterocedasticidad, autocorrelación).

• Observaciones influyentes y atípicos. Medidas para la detección.

• Multicolinealidad.

Modelos de regresión generalizados (Prof. Ramón Ferri). Sesión: 4 de junio.• Regresion de Poisson.

• Regresión de Cox.

• Regresión logística binaria y multinomial.

Introducción a las técnicas de muestreo (Prof. Ramón Ferri). Sesión: 5 de junio.• Muestreo aleatorio simple.

• Muestreo con probabilidades desiguales.

• Muestreo estratificado.

• Muestreo por conglomerados.

• Métodos de captura-recaptura.

Modelos de análisis de la varianza paramétricos y no paramétricos (Prof. Christian Acal). Sesión: 6 de junio.• Anova de 1 vía, comprobación de supuestos. Interpretación.

• Anova de 2 vías con y sin interacción.

• Análisis de la varianza multivariante.

• Anova con medidas repetidas.

Introducción al análisis de fiabilidad (Prof. Christian Acal). Sesión: 7 de junio.• Modelos de fallo.

• Distribuciones continuas.

• Test de K-S.

• Comparación de modelos.

Actividades paralelas:

Se propondrá a los alumnos la realización de ejemplos de aplicación para la realización de prácticas individualizadas y tutorizadas de forma personalizada. Esta parte constituirá la evaluación final que determinará el grado de aprovechamiento del curso. Para dicha supervisión y evaluación, los estudiantes serán repartidos entre el profesorado.

Python avanzado para ciencia e ingeniería

- Profesorado: José Vicente Pérez Peña (UGR)

- Duración: 20 horas presenciales.

- Fechas: 10, 11, 12, 13, 17, 18, 19, 20, 24, 25 de junio 2024

- Horario: De 09:00 h a 11:00 h.

- Lugar: Aula Juan Campos de la Facultad de Ciencias (Presencial)

Se necesita portátil propio (Mac o PC).

- Plazas y perfil: 15 plazas. Dirigido preferentemente a alumnos/as de segundo año de doctorado con conocimientos de Python.

Para este curso es necesario acreditar un conocimiento básico del lenguaje Python 3. Con el fin de evaluar los conocimientos de Python requeridos, antes del inicio del curso se realizará un cuestionario online a los solicitantes. Los estudiantes que no superen la prueba, no se admitirán en el curso.

- Plazo de inscripción: 14 a 19 de mayo de 2024.

- Forma de inscripción: Mediante el siguiente FORMULARIO

En caso de que haya más solicitudes que plazas se seleccionarán los alumnos/as según su adecuación al perfil del curso y el orden de inscripción.

- Justificación académica:

Python es uno de los mejores lenguajes para su uso científico y técnico. Tiene algunas características que lo hacen realmente interesante en este ámbito, como son; es interpretado, de alto nivel, muy fácil de aprender, fácilmente extensible y cuenta con una librería estándar con mucha funcionalidad. Este lenguaje está siendo actualmente utilizado por instituciones científicas como la NASA, JPL, y otras como Google, DreamWorks, Disney, etc. En el ámbito científico y técnico, python se está abriendo paso de forma firme gracias a librerías específicas como numpy, matplotlib y scipy. El uso de estas librerías ofrece a los usuarios de Python una infinidad de recursos matemáticos y científicos para la resolución de problemas complejos y la creación de gráficos de muy alta calidad. Algunas de las operaciones básicas utilizadas en cálculo y programación científico-técnica incluyen matrices, integrales, ecuaciones diferenciales, estadística, etc. Python en su paquete básico no cuenta por defecto con funciones para realizar este tipo de cálculos directamente. Así mismo, los tipos básicos de variables de Python no están optimizados para el manejo de gran cantidad de datos. NumPy y SciPy son dos librerías muy potentes que cuentan con toda esta funcionalidad de la que carece el paquete básico de Python, y por tanto que posibilitan la utilización de este lenguaje para fines científicos y técnicos. La librería de numpy se especializa en el procesado numérico utilizando matrices multidimensionales, y permite un cálculo matricial directo al igual que programas especializados como matlab. Así mismo cuenta con métodos y funciones para la creación, manejo, redimensionado, etc., de matrices, lo cual reduce considerablemente el esfuerzo de programación requerido en otros lenguajes. La librería de matplotlib es una librería gráfica que toma todas las ventajas de numpy. Permite la creación de infinidad de gráficos de alta calidad (ráster y vectorial), así como la modificación de todas sus características. Matplotlib no solo se integra perfectamente con numpy, sino que permite el lenguaje de marcado de LaTeX, pudiendo crear gráficos de muy alta calidad para publicaciones científicas e informes técnicos.

SciPy va un paso más allá, y utiliza toda la funcionalidad de numpy para realizar cálculos matemáticos avanzados como la integración, diferenciación, algebra lineal, no lineal, etc. También cuenta con multitud de funciones de alto nivel para el tratamiento estadístico de los datos. Una lista completa de todas las funciones de numpy, matplotlib y scipy ocuparía cientos de páginas, por lo que en este curso se tratarán las funciones más utilizadas. Se introducirá al alumno en las rutinas de trabajo con estas librerías y a la resolución de los problemas más comunes en ciencia e ingeniería. Con este curso también se pretende que el alumno tenga los conocimientos necesarios para entender la documentación de estas librerías con el fin de capacitarlo para poder utilizar funcionalidad específica de las mismas no tratada en este curso.

- Objetivos educativos, profesionales y competencias generales adquiridas

El alumno sabrá:

1.- Manejo de matrices multidimensionales con numpy

2.- Funciones básicas para la creación y utilización de matrices de numpy

3.- Lectura-escritura en disco de datos

4.- Creación y representación de funciones matemáticas

5.- Creación de distintos gráficos con matplotlib

6.- Modificación de símbolos y leyendas

7.- Análisis de imagen con scipy

El alumno será capaz de:

1.- Crear y modificar gráficos

2.- Integrar LaTeX directamente en un gráfico

3.- Representar funciones y resolver ecuaciones matemáticas

4.- Entender la documentación de las librerías de Python

5.- Realizar cálculos matemáticos de alto nivel y resolución de problemas complejos

- Programa formativo:

Tema 1. Manejo de datos con numpy (4h) Constantes y funciones de numpy. Arrays de numpy. Métodos para la creación de arrays. Operaciones con arrays. Indexado y slicing en arrays. Leer y guardar arrays en archivos de texto.

Tema 2. Representación gráfica con matplotlib (4h) Representación básica de funciones Representación de varias curvas. Representación de nube de puntos Representación de histogramas y boxplots. Definiendo colores y símbolos. Añadiendo leyendas y etiquetas. Control de ejes. Representación de múltiples figuras.

Tema 3. Análisis numérico con scipy (2h) Ajuste e interpolación de datos. Tratamiento multidimensional de imágenes con ndimage.

Tema 4. Breve introducción a cython (2h). Creación y compilación de scripts usando Cython. Elementos básicos del lenguaje. Optimización de código con Cython.

Introducción a Python: Elementos básicos del lenguaje

- Profesorado: Patricia Ruano Roca (UGR)

- Duración: 20 horas presenciales

- Fechas y horario: lunes a viernes del 8 al 19 de julio 2024. Horario de 12:00 h a 14:00 h.

- Modalidad: Virtual

- Lugar: Virtual.

- Plazas y perfil: 15 plazas/edición. Dirigido preferentemente a alumnos/as de primer año de doctorado.

- Inscripción: del 2 al 4 de julio 2024 a través del siguiente FORMULARIO

- Justificación académica:

Python es uno de los mejores lenguajes para su uso científico y técnico. Tiene algunas características que lo hacen realmente interesante en este ámbito, como son; es interpretado, de alto nivel, muy fácil de aprender, fácilmente extensible y cuenta con una librería estándar con mucha funcionalidad. Este lenguaje está siendo actualmente utilizado por instituciones científicas como la NASA, JPL, y otras como Google, DreamWorks, Disney, etc. Alguna de las características que hacen de Python el lenguaje ideal para cálculos científicos son:

- Es un lenguaje muy fácil de aprender, siendo el lenguaje más recomendado para usuarios que no cuentan con conocimientos de programación.

- Es de código libre, por lo que no requiere una licencia para su uso.

- Es multiplataforma, pudiéndose utilizar en diferentes Sistemas Operativos com MAC, LINUX, Windows, etc.

- Python es un lenguaje de programación real, con todas las características de un lenguaje de programación orientado a objetos, a diferencia de otros lenguajes como matlab que carecen de algunas funcionalidades en este sentido.

- Tiene multitud de módulos y librerías externos que realizan numerosas funciones de gran utilidad para científicos e ingenieros. A este respecto, módulos específicos para realizar cálculos científicos como numpy, matplotlib y scipy, han hecho que este lenguaje esté ganando cada vez más popularidad entre científicos e ingenieros.

- Se integra perfectamente con LaTeX, permitiendo el formateo de ecuaciones y la realización de figuras para artículos científicos o informes técnicos.

- Es extensible y altamente configurable. Librerías como matplotlib permiten realizar infinidad de gráficos de muy alta calidad e interactivos.

En este curso se verán los elementos básicos de un lenguaje de programación como Python; sintaxis, funciones principales, flujos condicionales y bucles, etc. El conocimiento de las bases del lenguaje es un paso previo fundamental para poder sacar el mayor rendimiento de las librerías específicas más utilizadas en los ámbitos científico y técnico.

- Objetivos educativos, profesionales y competencias generales adquiridas

El alumno sabrá:

1.- Los elementos básicos de un lenguaje de programación

2.- Tipos de variables y su manipulación

3.- Manipulación de listas, tuplas y diccionarios

4.- Flujos condicionales if y recursivos for

5.- Funciones básicas del lenguaje

6.- Creación de funciones propias

7.- Control de código y manejo excepciones

El alumno será capaz de:

1.- Crear scripts en python para resolver problemas

2.- Leer y analizar un programa escrito en Python

3.- Manejar los principales entornos de programación con IPython (Spyder y Jupyter)

4.- Leer y escribir datos en ficheros de texto

5.- Diseñar algoritmos para la resolución secuencial de problemas

6.- Depurar programas y reconocer los principales tipos de errores

- Programa:

Tema 1. Introducción (1h) Introducción a los lenguajes de programación Historia de Python Descarga e instalación de anaconda. La consola de Python. Partes principales del IDE Spyder.

Tema 2. Tipos básicos, variables y expresiones (4h) Tipos de datos en Python. Variables, operadores y expresiones. Instalar, importar y utilizar módulos en Python. Listas, tuplas y diccionarios.

Tema 3. Operadores y funciones (4h) Operador lógico if. Bucles for. Bucles while. Creación y utilización de funciones en Python.

Tema 4. Operación de entrada/salida y optimización de código (3h) Lectura de ficheros de texto. Escritura en archivos de texto. Módulos os y sys. Control de ficheros y directorios. Optimización de código. Tipos de errores principales en Python. Control de código y manejo excepciones.

Curso 2022/2023

Python avanzado para ciencia e ingeniería

- Profesorado: José Vicente Pérez Peña (UGR)

- Duración: 20 horas presenciales.

- Fechas y horario: SE CANCELA LA CELEBRACIÓN DE ESTE CURSO

- Lugar: por determinar (Presencial)

Se necesita portátil propio (Mac o PC).

- Plazas y perfil: 15 plazas. Dirigido preferentemente a alumnos/as de segundo año de doctorado con conocimientos de Python.

Para este curso es necesario acreditar un conocimiento básico del lenguaje Python 3. Con el fin de evaluar los conocimientos de Python requeridos, antes del inicio del curso se realizará un cuestionario online a los solicitantes. Los estudiantes que no superen la prueba, no se admitirán en el curso.

- Plazo de inscripción: por determinar.

- Forma de inscripción: a través de este FORMULARIO (se activará una vez empiece el plazo de solicitud)

En caso de que haya más solicitudes que plazas se seleccionarán los alumnos/as según su adecuación al perfil del curso y el orden de inscripción.

- Justificación académica:

Python es uno de los mejores lenguajes para su uso científico y técnico. Tiene algunas características que lo hacen realmente interesante en este ámbito, como son; es interpretado, de alto nivel, muy fácil de aprender, fácilmente extensible y cuenta con una librería estándar con mucha funcionalidad. Este lenguaje está siendo actualmente utilizado por instituciones científicas como la NASA, JPL, y otras como Google, DreamWorks, Disney, etc. En el ámbito científico y técnico, python se está abriendo paso de forma firme gracias a librerías específicas como numpy, matplotlib y scipy. El uso de estas librerías ofrece a los usuarios de Python una infinidad de recursos matemáticos y científicos para la resolución de problemas complejos y la creación de gráficos de muy alta calidad. Algunas de las operaciones básicas utilizadas en cálculo y programación científico-técnica incluyen matrices, integrales, ecuaciones diferenciales, estadística, etc. Python en su paquete básico no cuenta por defecto con funciones para realizar este tipo de cálculos directamente. Así mismo, los tipos básicos de variables de Python no están optimizados para el manejo de gran cantidad de datos. NumPy y SciPy son dos librerías muy potentes que cuentan con toda esta funcionalidad de la que carece el paquete básico de Python, y por tanto que posibilitan la utilización de este lenguaje para fines científicos y técnicos. La librería de numpy se especializa en el procesado numérico utilizando matrices multidimensionales, y permite un cálculo matricial directo al igual que programas especializados como matlab. Así mismo cuenta con métodos y funciones para la creación, manejo, redimensionado, etc., de matrices, lo cual reduce considerablemente el esfuerzo de programación requerido en otros lenguajes. La librería de matplotlib es una librería gráfica que toma todas las ventajas de numpy. Permite la creación de infinidad de gráficos de alta calidad (ráster y vectorial), así como la modificación de todas sus características. Matplotlib no solo se integra perfectamente con numpy, sino que permite el lenguaje de marcado de LaTeX, pudiendo crear gráficos de muy alta calidad para publicaciones científicas e informes técnicos.

SciPy va un paso más allá, y utiliza toda la funcionalidad de numpy para realizar cálculos matemáticos avanzados como la integración, diferenciación, algebra lineal, no lineal, etc. También cuenta con multitud de funciones de alto nivel para el tratamiento estadístico de los datos. Una lista completa de todas las funciones de numpy, matplotlib y scipy ocuparía cientos de páginas, por lo que en este curso se tratarán las funciones más utilizadas. Se introducirá al alumno en las rutinas de trabajo con estas librerías y a la resolución de los problemas más comunes en ciencia e ingeniería. Con este curso también se pretende que el alumno tenga los conocimientos necesarios para entender la documentación de estas librerías con el fin de capacitarlo para poder utilizar funcionalidad específica de las mismas no tratada en este curso.

- Objetivos educativos, profesionales y competencias generales adquiridas

El alumno sabrá:

1.- Manejo de matrices multidimensionales con numpy

2.- Funciones básicas para la creación y utilización de matrices de numpy

3.- Lectura-escritura en disco de datos

4.- Creación y representación de funciones matemáticas

5.- Creación de distintos gráficos con matplotlib

6.- Modificación de símbolos y leyendas

7.- Análisis de imagen con scipy

El alumno será capaz de:

1.- Crear y modificar gráficos

2.- Integrar LaTeX directamente en un gráfico

3.- Representar funciones y resolver ecuaciones matemáticas

4.- Entender la documentación de las librerías de Python

5.- Realizar cálculos matemáticos de alto nivel y resolución de problemas complejos

- Programa formativo:

Tema 1. Manejo de datos con numpy (4h) Constantes y funciones de numpy. Arrays de numpy. Métodos para la creación de arrays. Operaciones con arrays. Indexado y slicing en arrays. Leer y guardar arrays en archivos de texto.

Tema 2. Representación gráfica con matplotlib (4h) Representación básica de funciones Representación de varias curvas. Representación de nube de puntos Representación de histogramas y boxplots. Definiendo colores y símbolos. Añadiendo leyendas y etiquetas. Control de ejes. Representación de múltiples figuras.

Tema 3. Análisis numérico con scipy (2h) Ajuste e interpolación de datos. Tratamiento multidimensional de imágenes con ndimage.

Tema 4. Breve introducción a cython (2h). Creación y compilación de scripts usando Cython. Elementos básicos del lenguaje. Optimización de código con Cython.

Resonancia Magnética Nuclear, GERMN

Curso destinado a alumnos de TFM y doctorado con un enfoque práctico hacia la interpretación de espectros 1D y 2D.

- Programa:

Tema I. Origen de la señal de RMN y núcleos activos en RMN. Desplazamiento químico. Integración. Factores que afectan al desplazamiento químico: efectos inductivos, mesómeros, cargas netas, anisotropía, campos eléctricos, van der Waals, enlaces de hidrógeno, efecto isotópico, efecto del medio. 2 h.

Tema II. El acoplamiento escalar. Espectros de primer orden: notación, tipos de acoplamientos (nJ, n ≥ 2), efecto tejado, árboles de desdoblamiento. Equivalencia química y equivalencia magnética. Relaciones entre estructura y magnitud relativa de los acoplamientos nJHH. Acoplamientos heteronucleares. Desacoplamiento homo y heteronuclear. Acoplamientos de orden superior a 1. 3 h.

Tema III. Concepto de relajación y factores de los que depende. Relación entre tiempos de relajación y estructura. El efecto Overhauser nuclear. Relación entre NOE y estructura. 1 h.

Tema IV. RMN dinámica: escalas de tiempo en RMN, efectos en el desplazamiento químico y en las constantes de acoplamiento. 1 h.

Tema V. RMN-13C{1H}: medida de espectros (efecto del desacoplamientos de 1H). Desplazamiento químico. Factores que afectan al desplazamiento químico. Edición de espectros. 2 h.

Tema VI. Introducción a la RMN bidimensional. Tipos de espectros y ejemplo de aplicación (resolución de problema estructural analizando COSY, HSQC y NOESY, sin otros concimientos previos). 1 h.

Tema VII. Espectros COSY, COSYDQF, TOCSY (incluido TOCSY selectivo), HSQC, HMQC, HMBC, NOESY, HOESY. 2 h.

- Objetivos. Al finalizar el curso el alumno deberá saber: Las estrategias de asignación estructural mediante la medida de espectros de RMN de alta resolución. La obtención de información estructural derivada de los efectos de relajación y de los procesos dinámicos que afecten a la molécula problema.

- Tipo de docencia. En línea, mediante la plataforma virtual Blackboard.

- Profesor. Fernando López Ortiz, Universidad de Almería

- Con la colaboración de: Real Sociedad Española de Química (grupo especializado en resonancia magnética nuclear)

- Fechas. 7 - 28 de noviembre de 9 a 11 h según se indica en la planificación siguiente:

- Planificación:

| Lunes 7 | Jueves 10 | Lunes 21 | Jueves 24 | Lunes 28 | Jueves 1 |

|---|---|---|---|---|---|

| Tema I/2 h | Tema II/2 h | Tema II/1 h | Tema IV/1 h | Tema V/1 h | Tema VII/2 h |

| Tema III/1 h | Tema V/1 h | Tema VI/1 h |

- Forma y plazo de inscripción: del 17 al 28 de octubre de 2022 a través del siguiente FORMULARIO

- Evaluación. No se contemplan exámenes. En su lugar se puede proporcionar un certificado de participación si se ha asistido al menos al 80 % del curso.

Multivariate Exploratory Data Analysis (MEDA): Understanding by looking at data

- Date: 14-18 november 2022

- Participants: 30

- Place: aula B1 ETSIIT( E.T.S. de Ingenierías Informática y de Telecomunicación )

- Deadline for application: 17 october- 6 november 2022

- How to apply: Use this APLICATION FORM.

- NOTES

- The course will be held presentially. Prof. Bro will intervene by virtual connection

- The course will be held in English.

It is necessary to have at least a B1 level (preferably B2 or higher). You can indicate in the “Observations” section your level of English and, if it is the case, if you have a certificate. / Este curso se impartirá íntegramente en inglés. Es necesario contar como mínimo con un nivel B1 (preferentemente B2 o superior). Pude indicar en el apartado “Observaciones” su conocimientos de inglés y en su caso si dispone de certificado para acreditarlo.

- It is requiered basic knowledge of MatLab. Those students who can provide certification of that knowledge will have preference in admission.

- Own laptop required

- Course Goal

Do you have complicate data? Difficult to understand? With thousands of variables/observations? Or with too little observations? Missing data? Time series? Multiple sources? Big Data?

The course goal is to introduce the students to very powerful data visualization techniques to look into your data set. There is a bunch of Machine Learning (ML) methods that can do difficult tasks (like classification, modelling and prediction) using a black-box approach over data, deep learning being a popular example. This course shows a totally different approach to handling data, using ML only as an instrument (as a means) to understand your data. MEDA will show you how to look into your data set, regardless its complexity, so that you can find groups of individuals and classify them, understand relationships among measured quantities, detect anomalies, find parsimonious models, etc.

The course is led by Professor Rasmus Bro, world leading professor on data analysis in biological and food sciences, and his collaborator at the UGR Dr. José Camacho, specialist on data analysis in Big Data and Exploratory Data Analysis.

- Teaching hours: 30

- Teachers:

Professor Bro is a prominent figure in the field of data analysis and in particular in multivariate analysis. During the last two decades, Prof. Bro has been a principal actor in the development of multivariate analysis in chemical and biological applications in the chemometrics area, in which according to google scholar is the second top researcher. His vast research work is outstanding, presenting an H index equal to 78. Prof. Bro is the author of the most referenced tutorial of PARAFAC (2843 citations), the developer of an extensively used multi-way version of Partial Least Squares (N-PLS) and co-author of more than 200 publications mainly related to the use of multi-way analysis in real life applications. His contributions to the use of constrained modelling are also very relevant, including the use of sparse methodologies for data analysis, and he has co-authored relevant articles to the problem of data fusion, a main challenge in Big Data analyses. The international influence in the community of his course “Multi-way Analysis” and his monograph “Multi-way Analysis: applications in the chemical sciences” is widely recognized. Prof. Bro has taught courses on data analysis in dozens of public and private organizations around the world. From 2001, he is the head of ODIN, an industrial research consortium offering courses, workshops, international contacts and student collaboration.

José Camacho is full professor in the Department of Signal Theory, Networking and Communications and researcher in the Information and Communication Technologies Research Centre, CITIC for its initials in Spanish, both at the University of Granada, Spain. His research interests include exploratory data analysis, anomaly detection and optimization with multivariate techniques applied to data of very different nature, including personalized medicine and communication networks. He is especially interested in the use of exploratory data analysis to Big Data.

- Examination:

Every person analyze their own data under supervision of the teacher and writes a report. The report must be short and concise. A short description of the data and their background must be provided. A short description of aim of the present work must be provided. This aim is not necessarily the overall aim of the project from which the data stem (although this is of course nice). Rather the purpose should be chosen in order to test and evaluate the students’ ability to use the methods taught at the course. It is important to discuss in detail how the models have been critically used for the stated purposes.

- Schedule:

Day 1: PCA (Prof. Bro & Dr. Camacho)

| 8:30-9:30 | Welcome (Bro & Camacho) |

| 9:30-10:00 | Introduction and algebra without tears |

| 10:00-11:15 | Principal Component Analysis – PCA |

| 11:15-11:30 | Break |

| 11:30-12:00 | Software introduction (demos/hands-on) |

| 12:00-12:30 | Exercises – PCA |

| 12:30-13:30 | Validation, outliers – PCA |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises – PCA |

Day 2: PLS (Prof. Bro)

| 9:00-9:15 | PCA summary |

| 9:15-10:30 | Multivariate calibration - PLS |

| 10:30-10:45 | Break |

| 10:45-11:30 | Exercises – Multivariate calibration |

| 11:30-13:00 | Validation and outliers incl. exercises |

| 13:00-15:00 | Lunch |

| 15:00-16:00 | Preprocessing and nice to know |

| 16:00-16:15 | Break |

| 16:15-18:00 | Competition! |

Day 3: MEDA Toolbox (Dr. Camacho)

| 9:00-10:00 | Introduction to the MEDA Toolbox |

| 10:00-11:15 | Using the command line interface |

| 11:15-11:30 | Break |

| 11:30-12:30 | Advanced Exploratory Data Analysis |

| 12:30-13:30 | Exercises & Examples |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises |

Day 4: Big Data (Dr. Camacho)

| 9:00-11:00 | Extensions to Big Data: Big Observations |

| 11:00-11:30 | Break |

| 11:30-12:30 | Exercises |

| 12:30-13:30 | Extensions to Big Data: Big Variables |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises |

Day 5: Playing with your data I (Prof. Bro & Dr. Camacho)

Time will be devoted to analyze your own data under the supervision of the course monitors, who will guide you through different analysis techniques to pursue your goals.

| 9:00-14:00 | Playing with your data |

4th EUROMBR Summer School on Microfluidic (EUROMBR 2023)

- Esta escuela de verano está destinada, principalmente, a estudiantes de doctorado en las áreas de química, ingeniería química, bioquímica, biotecnología y farmacia, y su objetivo es la formación de jóvenes investigadores en el uso de los sistemas de microfluídica para la resolución de problemas reales, principalmente en los campos de desarrollo de bioprocesos (microbiorreactores) y biomedicina. Por ello, esta escuela contará con dos cursos prácticos paralelos:

- Training Course on Bioprocess Development of Microbiorreactors, de 5 días de duración (11 al 15

de septiembre)

- Training Course on Medical Applications of Microfluidics (11 al 13 de septiembre).

En cada uno de estos cursos se tratarán tanto aspectos teóricos como prácticos, destacando la realización de una gran cantidad de horas prácticas de laboratorio.

Toda la información sobre el programa se puede consultar en la web https://eurombr.ugr.es/ .

- Contacto: Jorge F. Fernández Sánchez (--LOGIN--94d036a22f173df1cceed7ff0f4b704eugr[dot]es y --LOGIN--651bcea8a333ddd63b793ace6d75aa97ugr[dot]es ).

- Inscripción: hasta el 15 de julio de 2023

El número de plazas es limitado, por lo que se atenderán las inscripciones por orden de registro.

- Precio:

- Training Course on Bioprocess Development of Microbiorreactors: 300 €

- Training Course on Medical Applications of Microfluidics: 200 €

Las inscripciones con fecha posterior al 15 de julio tendrán un sobrecargo. La cuota de inscripción al curso incluye la participación en las conferencias y sesiones prácticas de laboratorio, los materiales necesarios para llevar a cabo las diferentes actividades, cóctel de bienvenida, cafés, almuerzos, excursión y cóctel en un Carmen.

TALLER TEÓRICO-PRÁCTICO SOBRE FENÓMENOS INTERFACIALES

El dia 13 de Septiembre de 2023 se celebrará en la facultad de Ciencias de la Universidad de Granada el TALLER TEÓRICO-PRÁCTICO SOBRE FENÓMENOS INTERFACIALES, como actividad previa al VI Congreso de Jóvenes Investigadores e Investigadoras en Coloides e Interfases (JICI6, https://wpd.ugr.es/~jici6/).

Este taller pretende cubrir los fundamentos de la ciencia de superficies e interfases en una jornada con contenidos teóricos y clases prácticas en laboratorios especializados. El objetivo del taller es proporcionar una visión global de la potencialidad y multidisciplinariedad de los fenómenos interfaciales en la actualidad.

El proceso de inscripción está abierto hasta el 19 de mayo de 2023, inclusive.

Puedes encontrar toda la información, formulario de inscripción y novedades del evento en la página web:

http://wpd.ugr.es/~jici6/taller-teorico-practico-de-fenomenos-interfaciales/

AGORA AEROSOL TRAINING COURSE: CHARACTERIZATION OF ATMOSPHERIC AEROSOL USING IN-SITU AND REMOTE SENSING TECHNIQUES

Lugar y fecha:

Andalusian Global ObseRvatory of the Atmosphere, Instituto de Investigación del Sistema Tierra de Andalucía, Granada, Spain. June 12-17, 2023.

Descripción breve:

El proyecto ATMO-ACCESS apoya actividades innovadoras de formación y educación relacionadas con las infraestructuras de investigación atmosférica. Es crucial para el éxito futuro de las instalaciones atmosféricas europeas garantizar que las nuevas generaciones de investigadores adquieran conocimientos y habilidades para aprovechar todas las herramientas esenciales para su investigación. Esta capacitación en AGORA Aerosol Training School es la primera de tres sesiones innovadoras para agregar la dimensión de capacitación a las infraestructuras de investigación utilizando acceso físico, remoto y virtual.

Grupo objetivo:

El curso de formación está destinado principalmente a investigadores y técnicos del campo atmosférico. Los alumnos deben tener conocimientos previos sobre las ciencias de los aerosoles, al menos en una de las técnicas de medición de aerosoles. Podrían ser estudiantes de master, estudiantes de doctorado, científicos o técnicos que inician su carrera. Se requieren buenas habilidades de comunicación en inglés.

Número de participantes: 25

Contenidos del curso y resultados del aprendizaje:

Las conferencias brindan conocimientos fundamentales en técnicas novedosas y avanzadas para medir las propiedades de los aerosoles, cubriendo in situ, sensores remotos e instrumentos de laboratorio. Este curso de formación híbrido se realizará de forma presencial en el Observatorio Global de la Atmósfera de Andalucía (AGORA) en Granada (España), e incluirá una visita a la estación de Sierra Nevada y formación práctica en algunos instrumentos novedosos de aerosoles. Se combina con actividades a distancia la semana anterior (1,5 h al día, 2 días) y posterior al curso (3 h al día, 5 días). Las conferencias presenciales interactivas están previstas del lunes 12 al viernes 16 de junio (8:30 - 17:30). Todos los participantes obtendrán un certificado por su participación.

Ponentes:

Dr. Lucas Alados-Arboledas, University of Granada (Spain)

Dr. Andrés Alastuey, IDAEA-CSIC (Spain)

Dr. Elisabeth Andrews, NOAA (United States)

Dr. Martine Collaud-Coen, MeteoSwiss (Switzerland)

Dr. Oleg Dubovik, Centre National de la Recherche Scientifique (France)

Dr. Martin Gysel-Beer, Paul Scherrer Institute (Switzerland)

Dr. Stelios Kazadzis, World Radiation Center (Switzerland)

Dr. Anton Lopatin, GRASP SAS (France)

Dr. Griša Močnik, University of Nova Gorica (Slovenia)

Dr. Francisco Navas-Guzmán, University of Granada (Spain)

Dr. Doina Nicolae, INOE (Romania)

Dr. Gloria Titos, University of Granada (Spain)

Dr. Antonio Valenzuela, University of Granada (Spain)

Coordinadores: Dr. Lucas Alados Arboledas (alados@ugr.es) y Juan Luis Guerrero Rascado (rascado@ugr.es)

Más información en: https://atmosphere.ugr.es/en/about/presentation/agora_aerosol_training_course

Tecnología del vacío y sus aplicaciones. Espectrometría de masas cuadrupolar y Análisis de gases

Curso destinado a estudiantes de doctorado y master, usuarios y responsables de mantenimiento de sistemas de alto y ultra alto vacío: XPS, STM, sistemas de análisis de gases acoplados a termobalanzas, equipos de quimisorción.

- Programa

Día 1. Tecnología del vacío. (3,5 h aula)

1) Descripción aplicaciones en procesos industriales: envasado de alimentos, aeronáutica y aeroespacial, energía fotovoltaica y termosolar, crecimiento de capas finas: metalización faros coches, espejos telescopios, vidrios arquitectónicos.

2) Descripción aplicaciones en investigación: nanotecnología y aceleradores de partículas.

3) Actividades StartUp

Dia 2. Espectrometría de masas cuadrupolar (2,5 h aula / 1 h visita CIC)

1) Espectros de gases residuales en cámara de alto y ultra alto vacío.

2) Sistemas análisis de gases - Descripción aplicaciones.

3) Generación hidrógeno verde.

- Duración: 7 horas.

- Tipo de docencia: Presencial. Facultad de Ciencias - Sala de Medios Audio-Visuales (ubicada en el vestíbulo de la Facultad de Ciencias). Visita al Centro de Instrumentación Científica de la Universidad de Granada.

- Profesor: César Atienza. Experto en Tecnología del vacío y desarrollo de sistemas especiales. Ha impartido cursos y seminarios de Tecnología de Vacío, espectrometría de masas cuadrupolar y sistemas de análisis de gases en diversas universidades españolas y centros de investigación.

- Fechas: 13 y 14 de abril 2023.

- Horario: jueves 13 de 10:00 a 13:00 h y viernes 14 de 10:00 a 12:00h y de 12:00 a 13:00 h visita al Centro de Instrumentación Científica.

- Forma y plazo de inscripción: de 20 a 28 de marzo a través del siguiente FORMULARIO

- Evaluación: No se contemplan exámenes. En su lugar se puede proporcionar un certificado de participación si se ha asistido al menos al 80 % del curso.

Curso 2021/2022

Python avanzado para ciencia e ingeniería

- Profesorado: José Vicente Pérez Peña (UGR)

- Duración: 20 horas presenciales.

- Fechas y horario: 27, 28, 29 de Abril, 3, 4, 5, 6, 18, 19, 20 de Mayo 2022. De 16:00 a 18:00h.

- Lugar: Aula Juan Campos de la Facultad de Ciencias (Presencial)

Se necesita portátil propio (Mac o PC).

- Plazas y perfil: 15 plazas. Dirigido preferentemente a alumnos/as de segundo año de doctorado con conocimientos de Python.

Para este curso es necesario acreditar un conocimiento básico del lenguaje Python 3. Con el fin de evaluar los conocimientos de Python requeridos, antes del inicio del curso se realizará un cuestionario online a los solicitantes. Los estudiantes que no superen la prueba, no se admitirán en el curso.

- Plazo de inscripción: del 1 al 17 de abril de 2022

- Forma de inscripción: a través de este FORMULARIO

En caso de que haya más solicitudes que plazas se seleccionarán los alumnos/as según su adecuación al perfil del curso y el orden de inscripción.

- Justificación académica:

Python es uno de los mejores lenguajes para su uso científico y técnico. Tiene algunas características que lo hacen realmente interesante en este ámbito, como son; es interpretado, de alto nivel, muy fácil de aprender, fácilmente extensible y cuenta con una librería estándar con mucha funcionalidad. Este lenguaje está siendo actualmente utilizado por instituciones científicas como la NASA, JPL, y otras como Google, DreamWorks, Disney, etc. En el ámbito científico y técnico, python se está abriendo paso de forma firme gracias a librerías específicas como numpy, matplotlib y scipy. El uso de estas librerías ofrece a los usuarios de Python una infinidad de recursos matemáticos y científicos para la resolución de problemas complejos y la creación de gráficos de muy alta calidad. Algunas de las operaciones básicas utilizadas en cálculo y programación científico-técnica incluyen matrices, integrales, ecuaciones diferenciales, estadística, etc. Python en su paquete básico no cuenta por defecto con funciones para realizar este tipo de cálculos directamente. Así mismo, los tipos básicos de variables de Python no están optimizados para el manejo de gran cantidad de datos. NumPy y SciPy son dos librerías muy potentes que cuentan con toda esta funcionalidad de la que carece el paquete básico de Python, y por tanto que posibilitan la utilización de este lenguaje para fines científicos y técnicos. La librería de numpy se especializa en el procesado numérico utilizando matrices multidimensionales, y permite un cálculo matricial directo al igual que programas especializados como matlab. Así mismo cuenta con métodos y funciones para la creación, manejo, redimensionado, etc., de matrices, lo cual reduce considerablemente el esfuerzo de programación requerido en otros lenguajes. La librería de matplotlib es una librería gráfica que toma todas las ventajas de numpy. Permite la creación de infinidad de gráficos de alta calidad (ráster y vectorial), así como la modificación de todas sus características. Matplotlib no solo se integra perfectamente con numpy, sino que permite el lenguaje de marcado de LaTeX, pudiendo crear gráficos de muy alta calidad para publicaciones científicas e informes técnicos.

SciPy va un paso más allá, y utiliza toda la funcionalidad de numpy para realizar cálculos matemáticos avanzados como la integración, diferenciación, algebra lineal, no lineal, etc. También cuenta con multitud de funciones de alto nivel para el tratamiento estadístico de los datos. Una lista completa de todas las funciones de numpy, matplotlib y scipy ocuparía cientos de páginas, por lo que en este curso se tratarán las funciones más utilizadas. Se introducirá al alumno en las rutinas de trabajo con estas librerías y a la resolución de los problemas más comunes en ciencia e ingeniería. Con este curso también se pretende que el alumno tenga los conocimientos necesarios para entender la documentación de estas librerías con el fin de capacitarlo para poder utilizar funcionalidad específica de las mismas no tratada en este curso.

- Objetivos educativos, profesionales y competencias generales adquiridas

El alumno sabrá:

1.- Manejo de matrices multidimensionales con numpy

2.- Funciones básicas para la creación y utilización de matrices de numpy

3.- Lectura-escritura en disco de datos

4.- Creación y representación de funciones matemáticas

5.- Creación de distintos gráficos con matplotlib

6.- Modificación de símbolos y leyendas

7.- Análisis de imagen con scipy

El alumno será capaz de:

1.- Crear y modificar gráficos

2.- Integrar LaTeX directamente en un gráfico

3.- Representar funciones y resolver ecuaciones matemáticas

4.- Entender la documentación de las librerías de Python

5.- Realizar cálculos matemáticos de alto nivel y resolución de problemas complejos

- Programa formativo:

Tema 1. Manejo de datos con numpy (4h) Constantes y funciones de numpy. Arrays de numpy. Métodos para la creación de arrays. Operaciones con arrays. Indexado y slicing en arrays. Leer y guardar arrays en archivos de texto.

Tema 2. Representación gráfica con matplotlib (4h) Representación básica de funciones Representación de varias curvas. Representación de nube de puntos Representación de histogramas y boxplots. Definiendo colores y símbolos. Añadiendo leyendas y etiquetas. Control de ejes. Representación de múltiples figuras.

Tema 3. Análisis numérico con scipy (2h) Ajuste e interpolación de datos. Tratamiento multidimensional de imágenes con ndimage.

Tema 4. Breve introducción a cython (2h). Creación y compilación de scripts usando Cython. Elementos básicos del lenguaje. Optimización de código con Cython.

Introducción a Python: Elementos básicos del lenguaje

- Profesorado: Patricia Ruano Roca (UGR)

- Duración: 20 horas presenciales

- Fechas y horario: 23, 24, 25, 30, 31 de Mayo y 1, 2, 6, 7, 8 de Junio de 16:00 a 18:00 h

- Lugar: Aula Juan Campos de la Facultad de Ciencias (Presencial)

Se necesita portátil propio (Mac o PC).

- Plazas y perfil: 15 plazas/edición. Dirigido preferentemente a alumnos/as de primer año de doctorado.

- Inscripción: Del 28 de abril al 10 de mayo mediante este FORMULARIO.

- Justificación académica:

Python es uno de los mejores lenguajes para su uso científico y técnico. Tiene algunas características que lo hacen realmente interesante en este ámbito, como son; es interpretado, de alto nivel, muy fácil de aprender, fácilmente extensible y cuenta con una librería estándar con mucha funcionalidad. Este lenguaje está siendo actualmente utilizado por instituciones científicas como la NASA, JPL, y otras como Google, DreamWorks, Disney, etc. Alguna de las características que hacen de Python el lenguaje ideal para cálculos científicos son:

- Es un lenguaje muy fácil de aprender, siendo el lenguaje más recomendado para usuarios que no cuentan con conocimientos de programación.

- Es de código libre, por lo que no requiere una licencia para su uso.

- Es multiplataforma, pudiéndose utilizar en diferentes Sistemas Operativos com MAC, LINUX, Windows, etc.

- Python es un lenguaje de programación real, con todas las características de un lenguaje de programación orientado a objetos, a diferencia de otros lenguajes como matlab que carecen de algunas funcionalidades en este sentido.

- Tiene multitud de módulos y librerías externos que realizan numerosas funciones de gran utilidad para científicos e ingenieros. A este respecto, módulos específicos para realizar cálculos científicos como numpy, matplotlib y scipy, han hecho que este lenguaje esté ganando cada vez más popularidad entre científicos e ingenieros.

- Se integra perfectamente con LaTeX, permitiendo el formateo de ecuaciones y la realización de figuras para artículos científicos o informes técnicos.

- Es extensible y altamente configurable. Librerías como matplotlib permiten realizar infinidad de gráficos de muy alta calidad e interactivos.

En este curso se verán los elementos básicos de un lenguaje de programación como Python; sintaxis, funciones principales, flujos condicionales y bucles, etc. El conocimiento de las bases del lenguaje es un paso previo fundamental para poder sacar el mayor rendimiento de las librerías específicas más utilizadas en los ámbitos científico y técnico.

- Objetivos educativos, profesionales y competencias generales adquiridas

El alumno sabrá:

1.- Los elementos básicos de un lenguaje de programación

2.- Tipos de variables y su manipulación

3.- Manipulación de listas, tuplas y diccionarios

4.- Flujos condicionales if y recursivos for

5.- Funciones básicas del lenguaje

6.- Creación de funciones propias

7.- Control de código y manejo excepciones

El alumno será capaz de:

1.- Crear scripts en python para resolver problemas

2.- Leer y analizar un programa escrito en Python

3.- Manejar los principales entornos de programación con IPython (Spyder y Jupyter)

4.- Leer y escribir datos en ficheros de texto

5.- Diseñar algoritmos para la resolución secuencial de problemas

6.- Depurar programas y reconocer los principales tipos de errores

- Programa:

Tema 1. Introducción (1h) Introducción a los lenguajes de programación Historia de Python Descarga e instalación de anaconda. La consola de Python. Partes principales del IDE Spyder.

Tema 2. Tipos básicos, variables y expresiones (4h) Tipos de datos en Python. Variables, operadores y expresiones. Instalar, importar y utilizar módulos en Python. Listas, tuplas y diccionarios.

Tema 3. Operadores y funciones (4h) Operador lógico if. Bucles for. Bucles while. Creación y utilización de funciones en Python.

Tema 4. Operación de entrada/salida y optimización de código (3h) Lectura de ficheros de texto. Escritura en archivos de texto. Módulos os y sys. Control de ficheros y directorios. Optimización de código. Tipos de errores principales en Python. Control de código y manejo excepciones.

Scientific writing

A cargo del Centro de Lenguas Modernas

Duración: 30 h

- 20 h instrucción-producción

- 10 h tutorización individual

Fechas

- 1ª edición: 4 - 25 abril 2022

- 2ª edición: 16 - 30 mayo 2022

- 3ª edición: 13 - 29 junio 2022

Horario

- de 9:00 h a 11:00 h

Lugar

- Instrucción-producción: online sobre plataforma Moodle: AulaVirtual CLM

- Tutorización individual: medios electrónicos

Plazo de inscripción

- Curso 1ª edición: 7 - 17 marzo 2022

- Curso 2ª edición: del 25 de abril al 2 de mayo 2022r

- Curso 3ª edición: de 23 a 30 de mayo

Forma de inscripción

A través del formulario accesible en el siguiente:

ENLACE DE INSCRIPCIÓN

Plazas

- 25 plazas por curso

Selección y requisitos

- La selección se realizará atendiendo a los puntos siguientes y por estricto orden de llegada de solicitudes.

- Matrícula en segundo año o superior (quedan excluidos alumnos de primer año).

- El solicitante deberá indicar en el formulario de solicitud si dispone de certificado de un nivel lingüístico en inglés igual o superior a B2. En caso de ser seleccionado, deberá enviar antes de empezar el curso dicho certificado a --LOGIN--522adeff6483f5d2baffecdfddcafe85ugr[dot]es . En caso de no hacerlo, perderá el puesto.

- Tendrán preferencia los que acrediten B2 o superior. No obstante, en caso de plazas vacantes el CLM llevará a cabo una prueba de nivel por orden de llegada de solicitudes hasta cubrir las plazas.

- No se guardarán plazas en lista de espera para ediciones subsiguientes en el mismo curso académico y en cursos siguientes.

Programa de la actividad

- 1. Introduction.

1.1 English as a lingua franca in the scientific world. 1.2 Types of papers.

- 2. Organization.

2.1 Sections. 2.2 Content. 2.3 Format and Layout. 2.4 Common errors.

- 3. Language.

3.1 Syntax and sentence structure. 3.2 Semantics and terminology. 3.3 Style and punctuation. 3.4 Common errors.

- 4 Strategies.

4.1 Keeping notes, annotations, notekeeping systems. 4.2 Keeping track of references. 4.3 Translation: problems and pitfalls. 4.4 Revising. 4.5 Expectations: Style guides, avoiding plagiarism, bibliography. 4.6 Useful links and tools.

Escritura de textos científicos con LaTeX y control de versiones con Git

- Profesorado: Miguel Burgos Poyatos. Dpto. de Genética. Facultad de Ciencias.

- Duración del curso (horas teóricas/prácticas): 20 horas en modalidad virtual + 20 horas no presenciales/trabajo personal

- Calendario y horario: 7, 9, 11, 14, 16, 18 y 21 de marzo 2022 en clases de 3 horas

- Lugar de impartición: Virtual

- Plazas y perfil (año de matriculación en doctorado):

Se ofertan 20 plazas. Es posible inscribirse durante cualquier año del doctorado. El taller está abierto tanto a doctorandos, tanto a tiempo completo como parcial.

- Necesidad de acreditación de conocimientos previos: No es necesario acreditar conocimientos previos.

- Evaluación:

Los alumnos crean un repositorio Git para el curso en http://bitbucket.org donde trabajan durante todo el taller y lo comparten con el profesor que, de esta forma puede seguir todo el trabajo que realizan los alumnos tanto durante las horas presenciales como en las no presenciales. Además, un Foro en la plataforma MOODLE permite la comunicación entre todos los participantes y la resolución de dudas y cuestiones de forma abierta y visible para todos los alumnos. Al final del taller el repositorio deberá contener la presentación de un texto científico que incluya bibliografía y diversos tipos de índices así como el historial de cambios de los archivos generados y situados bajo el control de Git. Siendo evaluado por el profesor responsable de la actividad.

- Inscripción:

La inscripción se realizará a través del siguiente ENLACE (se activará al inicio del plazo de inscripción)

- Plazo de solicitud: Del 14 al 20 de febrero de 2022

Para inscribirse hay que registrarse como usuario de la plataforma tras picar sobre el enlace del curso. Esto puede hacerse en cualquier momento aunque no esté abierto el plazo de matrícula. Cuando se abra, al picar sobre el curso se tendrá la posibilidad de inscribirse hasta que se complete el número de inscripciones.

- Justificación académica:

El taller está directamente enfocado a la escritura de la Tesis Doctoral. Los alumnos aprenden a utilizar el sistema de composición de textos LaTeX para escribir textos científicos, manejo automático de la bibliografía, y generar documentos en distintos formatos a partir del código fuente. Asimismo aprenden a utilizar el sistema de control de versiones Git, que resulta de especial interés para la administración de trabajo colaborativo, como la redacción conjunta de artículos de investigación o las correcciones de la memoria de la Tesis doctoral por parte de sus directores, por lo que es recomendable que tanto alumnos como sus directores asistan conjuntamente a este taller.

LaTeX Avanzado

Curso 2021/2022

Hay vida después de Word y PowerPoint!. Este curso está orientado al uso avanzado de LaTeX (software libre), para el maquetado de alta calidad de documentos técnicos y científicos. Se profundizará en la elaboración de material gráfico de interés en diferentes áreas de la Ciencia, Tecnología, e Ingeniería. Está especialmente orientado a alumnos de Doctorado y Master que necesitan publicar artículos, informes técnicos, proyectos, Tesis o Libros.

- Modo de solicitud: del 1 al 23 de marzo 2022 a través del siguiente enlace: LaTeX Avanzado: Aplicación en Ciencias, Tecnologías e Ingenierías

- Fechas y horario: 4 a 8, 19 a 22 de abril y lunes 25 de Abril 2022 de 10-12hrs.

- Plazas: 20.

- Lugar: 4 a 8, 21, 22 y 25 de abril en aula O09 Facultad de Ciencias, 19 y 20 abril en el aula O06 Facultad de Ciencias

- Motivación:

El curso surge para dotar al alumnado de doctorado y máster de unas herramientas informáticas apropiadas para aumentar su productividad científica. Tiene como objetivo facilitar el proceso de elaboración de los resultados de investigación, haciendo hincapié en la generación de material gráfico. LaTeX es la herramienta ideal, pero debido a la gran cantidad de opciones disponibles, puede parecer difícil de dominar. Este curso tiene como principal objetivo guiar al alumnado de una manera sencilla y gradual para que se conviertan en usuario avanzado de LaTeX.

- Requisitos previos:

Conocimientos básicos de LaTeX. Que preferentemente deberían incluir: instalación, compilación, visor/editor de documentos. Se recomienda saber elaborar un documento básico, y conocer funcionalidades elementales como: tablas, bloques, comandos básicos, etc.

- Perfil:

El curso está dirigido a estudiantes de la Escuela de Doctorado de Ciencias, Tecnologías e Ingenierías (EDCTI)

- Contenidos:

- Módulo 1: Maquetación de textos en LaTeX y Beamer para presentaciones.

- Módulo 2: Gráficos Vectoriales y uso de paquetes CTAN en LaTeX Ciencias, Tecnologías e Ingenierías.

- Módulo 3: Herramientas avanzadas en plantillas de LaTeX

- Duración:

20 hrs lectivas presenciales (teórico prácticas), y 32 hrs de trabajo del alumno (2 créditos ECTS). Clases de 2 hrs/diarias. Horario de mañana durante 2 semanas.

- Profesorado responsable:

- Jose A. Dobado Catedrático de Univ.). Dpto. Química Orgánica. Fac. de Ciencias.

- Isaac Vidal Daza (Escala Técnica Informática). Apoyo a la Docencia. CSIRC

- Evaluación:

La superación del curso requerirá:

- Asistencia de al menos 70 % de las sesiones (50 % puntuación).

- Elaboración de un documento maquetado con LaTeX (25 % puntuación).

- Defensa oral con Beamer del trabajo realizado. (25 % puntuación).

- Objetivos de Aprendizaje:

- Adquirir un nivel avanzado en la maquetación de textos científicos.

- Desarrollo de destrezas informáticas orientadas a la mejora de la productividad en el desarrollo de las tareas investigadoras.

- Programa:

MÓDULO 1: Uso Avanzado de LaTeX para maquetación de textos y Beamer para presentaciones (8 hrs)

Día 1: LaTeX avanzado (2 hrs)

- diseño de tablas, trabajo con imágenes y creación de gráficos

- ecuaciones y fórmulas

- funcionalidades avanzadas en LaTeX

Día 2: Generación de presentaciones con Beamer (2 hrs)

- uso de temas y apariencia, organización de contenido

- creación de diapositivas, ventanas, bloques y entornos

- plantillas de presentaciones y contenido dinámico

Día 3: Bases de datos con Biber y BibTeX (2 hrs)

- estilos bibliográficos, personalización

- bases de datos bibliográficas

- uso de internas/externas/varias

Día 4: Uso de plantillas con LaTeX para el maquetado de los resultados de la investigación (2 hrs)

- Plantillas de artículos científicos (ACS, RSC, Wiley, Elsevier, etc.)

MÓDULO 2: Gráficos vectoriales y uso de paquetes de LaTeX en Ciencias, Tecnologías e Ingeniería (6 hrs)

Día 5: PGF/TikZ (2 hrs)

- elementos básicos, líneas, caminos, sombreado, formas, colores

- otros comandos: nodos, variables, contadores, ciclos, recorte, alcance

- uso de librerías y ejemplos de dibujos

Días 6-7: Paquetes CTAN de CIENCIAS, TECNOLOGÍAS E INGENIERÍAS (4 hrs)

- dibujo de fórmulas química, reacciones y moléculas.

- gráficas de alineado de nucleótidos, péptidos, etc

- dibujo de circuitos eléctricos.

- escritura de algoritmos, códigos y diagramas de flujo

- dibujo de diagramas en ingeniería civil y de una planta química

MÓDULO 3: Herramientas avanzadas en plantillas de LaTeX y presentación de trabajos (6 hrs)

Días 8-9: Maquetación avanzada en LaTeX (4 hrs)

- Tesis Doctorales

- técnicas avanzadas de índices y glosarios

Día 10: Presentación de trabajos (2 hrs)

- mini-exposiciones de trabajos orales y escritos

- discusión de resultados

- Contacto:

Jose A. Dobado Facultad de ciencias

http://www.ugr.es/local/dobado

dobado@ugr.es

Inteligencia Artificial en 360º

- Descripción breve

Es notorio que la Inteligencia Artificial (I.A.) permea todas las áreas de conocimiento y puede tener un impacto relevante en cuestiones sociales y económicas. Sin embargo, también es notorio que en muchos casos no se tiene conocimiento riguroso de sus potencialidades y limitaciones, entendiéndose más como un arcano con nombre bonito que como una disciplina científica bien asentada, que puede proporcionar soluciones a problemas para los que no las hay en todos los ámbitos del saber, y muy particularmente para muchas de las líneas de investigación más avanzadas (en las que se inscriben las tesis doctorales).

De cara a abrir ventanas de oportunidad para la investigación a partir de técnicas y modelos basados en I.A., es fundamental que los doctorandos conozcan de qué hablamos cuando hablamos de esa materia, cuáles son sus limitaciones y cuales sus perspectivas a corto plazo, desde un punto de vista científico, solido y riguroso.

En esta actividad de carácter esencialmente transversal y de máximo rigor científico, se plantea como objetivo principal clarificar las cuestiones básicas asociadas con la I.A., desterrar algunos de los mitos más usuales y proveer una explicación clara y sencilla de las principales técnicas que permiten la construcción de sistemas basados en IA.

- Ponentes

- David A. Pelta Mochcovsky. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

- Carlos Cruz Corona. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

- José Luis Verdegay Galdeano. Dpto de Ciencias de la Computación e Inteligencia Artificial. ETSI Informática y de Telecomunicación

- Perfil

Dirigido a estudiantes de doctorado de la Escuela de Doctorado de Ciencias, Tecnologías e Ingenierías (EDCTI). En caso de sobrar plazas podrán ofrecerse a doctorandos de las Escuelas de Ciencias de la Salud (EDCS) y Humanidades, Ciencias Sociales y Jurídicas (EDHCSJ) que lo hayan solicitado.

- Contenidos

- Un recorrido histórico por la IA.

- Representación del conocimiento.

- “Machine Learning”.

- Métodos de Búsqueda y Optimización.

- Procesamiento del lenguaje natural.

- Técnica de Recuperación de la Información.

- Procesamiento de Imágenes y Video.

- Robótica e IA.

- Plazo de solicitud: 20 diciembre 2021 a 13 enero 2022

- Forma de solicitud: a través de este FORMULARIO

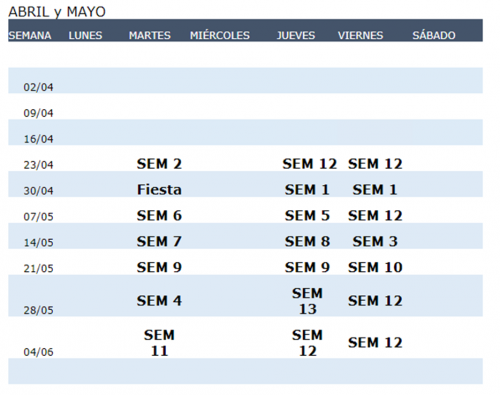

- Sesiones: Lunes 31/1, Jueves 3/2, Lunes 7/2, Jueves 10/2

Horario: 16:00 a 20:00hs

Seminario de Aplicaciones de IA en fecha por confirmar

- Nº de plazas: 30

- Lugar (pendiente de confirmación): Escuela Técnica Superior de Ing. Informática y de Telecomunicación

El curso tendrá modalidad presencial. Los participantes que superen la evaluación, obtendrán un diploma de aprovechamiento del curso. Aquellos participantes que no la superen, obtendrán un diploma de asistencia.

A los solicitantes que no obtengan una plaza, se les ofrecerá la posibilidad de asistir como oyentes mediante conexión en streaming

- Evaluación:

La superación del curso requerirá:

1) la asistencia a (al menos) el 70% de las sesiones.

2) Realización de un informe bibliográfico.

Se podrá plantear de acuerdo a las dos vías siguientes:

a) Dado un problema de interés provisto por el/la estudiante, el informe recogerá que técnicas de IA se han aplicado para su resolución.

b) Dada una técnica de interés para el/la estudiante (por ej. técnicas de aprendizaje), el informe recogerá que problemas de su área se han resuelto con dicha técnica.

Los responsables del curso estarán abiertos a otras propuestas de trabajo.

Técnicas estadísticas básicas aplicadas en Ciencias Experimentales: fundamentos, interpretación e implementación en R

Curso 2021/2022

- Modalidad: presencial

- Lugar: Aula Inf O04, zona de Matemáticas de la Facultad de Ciencias

- Plazas: 25

- Duración: 20 horas

- Periodo de impartición: 20 a 27 enero 2022

- Perfil del estudiante:

20 y 21 de enero: De 9 a 13 horas

24 a 27 de enero: De 9 a 12 horas

- Plazo de solicitud: Del 15 de diciembre 2021 a 10 enero 2022 a través del siguiente formulario:

ENLACE DE INSCRIPCIÓN

2ª EDICIÓN

- Fechas previstas para la actividad: 28 y 29 y 3 a 6 de mayo 2022

28 Y 29 de abril: De 9 a 13 horas

3 a 6 de mayo: De 9 a 12 horas

- Lugar de celebración:

28 de abril de 9 a 13 horas (Aula A20. Facultad de Ciencias)

29 de abril de 9 a 13 horas (Aula O04. Facultad de Ciencias)

3 y 4 de mayo de 9 a 12 horas (Aula O04. Facultad de Ciencias)

5 de mayo de 9 a 12 horas (Aula A20. Facultad de Ciencias)

6 de mayo de 9 a 12 horas (Aula O04. Facultad de Ciencias)

- Justificación académica del curso:

Es incuestionable la importancia que en las últimas décadas ha experimentado la aplicación de numerosas técnicas probabilístico-estadísticas en múltiples campos de aplicación. La razón última de ello viene motivada por la necesidad de describir y explicar la evolución de fenómenos, no sólo desde un punto de vista cualitativo sino cuantitativo, a la vez que se hace imprescindible en múltiples ocasiones poder inferir comportamientos futuros de los sistemas que son objeto de estudio.

El objetivo del curso es presentar una panorámica general, sobre todo desde el punto de vista de la aplicación de las técnicas presentadas en múltiples campos. En ese sentido, la idea principal de esta actividad es ilustrar a los alumnos sobre técnicas y métodos estadísticos mostrando una visión general de sus fundamentos así como una perspectiva de aplicaciones en diversos campos. Se hará especial hincapié sobre los fundamentos, condiciones de aplicabilidad e interpretación de resultados que ayuden a una mejor descripción de los fenómenos estudiados por los alumnos en el desarrollo de sus investigaciones. Otro de los objetivos del curso es el de mostrar la implementación de estas técnicas mediante R, introduciendo al alumno en el empleo de uno de los programas que mayor difusión ha adquirido en los últimos años.

- Programa:

1. Principios generales de inferencia. Modelos básicos: Problema de una muestra. Problema de dos muestras independientes y apareadas. Contrastes paramétricos y no paramétricos para una y dos muestras. M. Mar Rueda. 4 horas. 20 de enero.

2. Análisis de datos categóricos: Independencia y asociación en tablas bidimensionales. Independencia condicional y asociación parcial. Metodología de Mantel-Hanzel. Ana Aguilera. 4 horas. 21 de enero.

3. Modelos de regresión: Fco. De Asis Torres. 6 horas. 24 y 25 de enero.

a. Regresión lineal simple y múltiple.

b. Regresión logística binomial y multinomial. Regresión de Poisson. Regresión de Cox.

4. Técnicas de Análisis Multivariante: Modelo Lineal Multivariante: modelo de Regresión lineal múltiple multivariante y técnicas tipo MANOVA. Técnicas de reducción de dimensiones. Técnicas de clasificación automática. Beatriz Cobo. 6 horas. 26 y 27 de enero.

- Actividades paralelas:

Se propondrá a los alumnos la realización de ejemplos de aplicación para la realización de prácticas individualizadas y tutorizadas de forma personalizada. De forma alternativa, esas prácticas podrían consistir en el asesoramiento estadístico sobre problemas concretos relacionados con el desarrollo de su tesis doctoral. Esta parte constituirá la evaluación final que determinará el grado de aprovechamiento del curso. Para dicha supervisión y evaluación, los estudiantes serán repartidos entre el profesorado.

- Ponentes:

Dra. María del Mar Rueda García.

Dra. Ana María Aguilera del Pino.

Dra. Beatriz Cobo Rodríguez.

Dr. Francisco de Asís Torres Ruiz.

Multivariate Exploratory Data Analysis (MEDA): Understanding by looking at data(21-22)

- Date: 9-13 May 2022

- Participants: 30

- Deadline for application: 7-25 April 2022

- How to apply: Use this APLICATION FORM.

- NOTES

- The course will be held presentially. Prof. Bro will intervene by virtual connection

- The course will be held in English.

It is necessary to have at least a B1 level (preferably B2 or higher). You can indicate in the “Observations” section your level of English and, if it is the case, if you have a certificate. / Este curso se impartirá íntegramente en inglés. Es necesario contar como mínimo con un nivel B1 (preferentemente B2 o superior). Pude indicar en el apartado “Observaciones” su conocimientos de inglés y en su caso si dispone de certificado para acreditarlo.

- It is requiered basic knowledge of MatLab. Those students who can provide certification of that knowledge will have preference in admission.

- Course Goal

Do you have complicate data? Difficult to understand? With thousands of variables/observations? Or with too little observations? Missing data? Time series? Multiple sources? Big Data?

The course goal is to introduce the students to very powerful data visualization techniques to look into your data set. There is a bunch of Machine Learning (ML) methods that can do difficult tasks (like classification, modelling and prediction) using a black-box approach over data, deep learning being a popular example. This course shows a totally different approach to handling data, using ML only as an instrument (as a means) to understand your data. MEDA will show you how to look into your data set, regardless its complexity, so that you can find groups of individuals and classify them, understand relationships among measured quantities, detect anomalies, find parsimonious models, etc.

The course is led by Professor Rasmus Bro, world leading professor on data analysis in biological and food sciences, and his collaborator at the UGR Dr. José Camacho, specialist on data analysis in Big Data and Exploratory Data Analysis.

- Teaching hours: 30

- Teachers:

Professor Bro is a prominent figure in the field of data analysis and in particular in multivariate analysis. During the last two decades, Prof. Bro has been a principal actor in the development of multivariate analysis in chemical and biological applications in the chemometrics area, in which according to google scholar is the second top researcher. His vast research work is outstanding, presenting an H index equal to 78. Prof. Bro is the author of the most referenced tutorial of PARAFAC (2843 citations), the developer of an extensively used multi-way version of Partial Least Squares (N-PLS) and co-author of more than 200 publications mainly related to the use of multi-way analysis in real life applications. His contributions to the use of constrained modelling are also very relevant, including the use of sparse methodologies for data analysis, and he has co-authored relevant articles to the problem of data fusion, a main challenge in Big Data analyses. The international influence in the community of his course “Multi-way Analysis” and his monograph “Multi-way Analysis: applications in the chemical sciences” is widely recognized. Prof. Bro has taught courses on data analysis in dozens of public and private organizations around the world. From 2001, he is the head of ODIN, an industrial research consortium offering courses, workshops, international contacts and student collaboration.

José Camacho is full professor in the Department of Signal Theory, Networking and Communications and researcher in the Information and Communication Technologies Research Centre, CITIC for its initials in Spanish, both at the University of Granada, Spain. His research interests include exploratory data analysis, anomaly detection and optimization with multivariate techniques applied to data of very different nature, including personalized medicine and communication networks. He is especially interested in the use of exploratory data analysis to Big Data.

- Examination:

Every person analyze their own data under supervision of the teacher and writes a report. The report must be short and concise. A short description of the data and their background must be provided. A short description of aim of the present work must be provided. This aim is not necessarily the overall aim of the project from which the data stem (although this is of course nice). Rather the purpose should be chosen in order to test and evaluate the students’ ability to use the methods taught at the course. It is important to discuss in detail how the models have been critically used for the stated purposes.

- Schedule: ONLINE

Day 1: PCA (Prof. Bro & Dr. Camacho)

| 8:30-9:30 | Welcome (Bro & Camacho) |

| 9:30-10:00 | Introduction and algebra without tears |

| 10:00-11:15 | Principal Component Analysis – PCA |

| 11:15-11:30 | Break |

| 11:30-12:00 | Software introduction (demos/hands-on) |

| 12:00-12:30 | Exercises – PCA |

| 12:30-13:30 | Validation, outliers – PCA |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises – PCA |

Day 2: PLS (Prof. Bro)

| 9:00-9:15 | PCA summary |

| 9:15-10:30 | Multivariate calibration - PLS |

| 10:30-10:45 | Break |

| 10:45-11:30 | Exercises – Multivariate calibration |

| 11:30-13:00 | Validation and outliers incl. exercises |

| 13:00-15:00 | Lunch |

| 15:00-16:00 | Preprocessing and nice to know |

| 16:00-16:15 | Break |

| 16:15-18:00 | Competition! |

Day 3: MEDA Toolbox (Dr. Camacho)

| 9:00-10:00 | Introduction to the MEDA Toolbox |

| 10:00-11:15 | Using the command line interface |

| 11:15-11:30 | Break |

| 11:30-12:30 | Advanced Exploratory Data Analysis |

| 12:30-13:30 | Exercises & Examples |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises |

Day 4: Big Data (Dr. Camacho)

| 9:00-11:00 | Extensions to Big Data: Big Observations |

| 11:00-11:30 | Break |

| 11:30-12:30 | Exercises |

| 12:30-13:30 | Extensions to Big Data: Big Variables |

| 13:30-15:30 | Lunch |

| 15:30-17:00 | Exercises |

Day 5: Playing with your data I (Prof. Bro & Dr. Camacho)

Time will be devoted to analyze your own data under the supervision of the course monitors, who will guide you through different analysis techniques to pursue your goals.

| 9:00-14:00 | Playing with your data |

Curso de Tecnología del vacío y sus aplicaciones. Espectrometría de masas cuadrupolar y Análisis de gases

Curso destinado a estudiantes de doctorado y master, usuarios y responsables de mantenimiento de sistemas de alto y ultra alto vacío: XPS, STM, sistemas de análisis de gases acoplados a termobalanzas, equipos de quimisorción.

- Programa

Día 1. Tecnología del vacío. (3,5 h aula)

1) Descripción aplicaciones en procesos industriales: envasado de alimentos, aeronáutica y aeroespacial, energía fotovoltaica y termosolar, crecimiento de capas finas: metalización faros coches, espejos telescopios, vidrios arquitectónicos.

2) Descripción aplicaciones en investigación: nanotecnología y aceleradores de partículas.

3) Actividades StartUp

Dia 2. Espectrometría de masas cuadrupolar (2,5 h aula / 1 h visita CIC)

1) Espectros de gases residuales en cámara de alto y ultra alto vacío.

2) Sistemas análisis de gases- Descripción aplicaciones.

3) Generación hidrógeno verde.

- Duración: 7 horas.

- Tipo de docencia: Presencial. Facultad de Ciencias - Aula A20. Visita al Centro de Instrumentación Científica.

- Profesor: César Atienza. Experto en Tecnología del vacío y desarrollo de sistemas especiales. Ha impartido cursos y seminarios de Tecnología de Vacío, espectrometría de masas cuadrupolar y sistemas de análisis de gases en diversas universidades españolas y centros de investigación.

- Fechas: 30 y 31 de mayo 2022 de 9:30 a 13 h.

- Forma y plazo de inscripción: del 25 de abril al 9 de mayo a través del siguiente FORMULARIO

Plazo de solicitud AMPLIADO hasta 16 de mayo 2022

- Evaluación: No se contemplan exámenes. En su lugar se puede proporcionar un certificado de participación si se ha asistido al menos al 80 % del curso.

Creatividad, integridad y comunicación en ciencia

- Profesorado: Isabel Reche Cañabate y Francisco Perfectti Álvarez, Departamentos de Ecología y Genética, Facultad de Ciencias.

- Duración: 30 horas lectivas presenciales y 10 horas de trabajo no presencial y tutoría grupal (presencial).

- Fechas y horario: Miércoles, jueves y viernes de 9 a 12h. los días 12, 13, 14, 19, 20, 21, 26, 27, 28 y 31 de enero de 2022

- Lugar: Sala de Medios Audio-Visuales (Facultad de Ciencias)

- Plazas: 25 plazas.

- Perfil : El curso está dirigido a estudiantes de la Escuela de Doctorado de Ciencias, Tecnologías e Ingenierías (EDCTI). Se dará preferencia a estudiantes que estén cursando el primer año de doctorado, pero también está abierto a estudiantes de otros años en caso de plazas vacantes. No es necesario acreditar conocimientos previos.

- Plazo de inscripción: del 9 al 22 de diciembre de 2022

- Forma de inscripción: a través del siguiente FORMULARIO